Architecte Big Data pour le Hub Entreprise - Équipe DGREA (Gestion de la Relation Entreprise & Aides) 2024

Conception et implémentation d'une plateforme de données unifiée pour la consolidation et la distribution des informations relatives aux établissements

• Orchestration d'un data lake centralisé, agrégeant l'ensemble des connaissances de France Travail sur les établissements

• Optimisation des ressources de calcul et de stockage pour le traitement des données à grande échelle

• Déploiement et configuration d'une infrastructure Big Data robuste, incluant la mise en place de pipelines ETL et de processus de génération de DDL

• Implémentation d'un système d'ingestion de données dans Hive, supportant les modes full et incrémental (delta)

• Élaboration et exécution de suites de tests exhaustives : unitaires, d'intégration et de non-régression

• Mise en œuvre de l'intégration et du déploiement continus (CI/CD) via Concourse pour l'automatisation des flux de données

• Orchestration des workflows de production multi-environnements à l'aide de TWS d'IBM

• Conception de tableaux de bord automatisés pour le suivi des déploiements et de l'ingestion des données

• Optimisation des performances via le paramétrage fin des jobs Hive et l'ajustement des ressources allouées

• Intégration de Solr pour l'indexation et l'accélération des requêtes sur le Dataset

• Évolution continue du modèle de données, intégration de nouvelles sources et adaptation aux besoins des consommateurs

• Mise en place d'interfaces d'export vers les CRM Salesforce et Dynamics pour une exploitation optimale des données consolidées

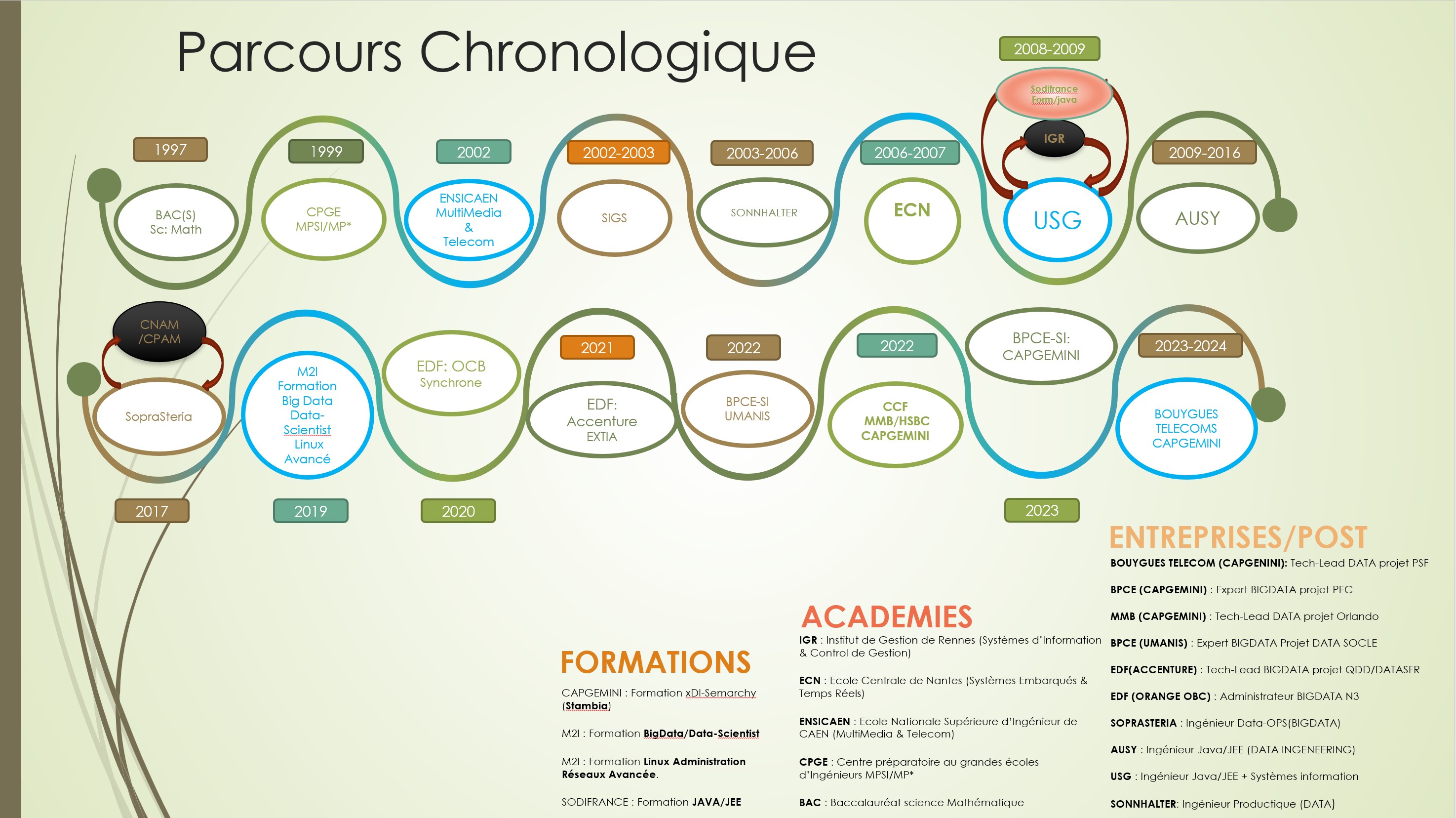

TimeLine

TimeLine